Beteja për një AI etike në konferencën më të madhe të mësimit të makinerisë

Paragjykimi dhe prospektet e dëmit shoqëror në rritje në raport me kërkimet për inteligjencën artificiale - nuk është e qartë se kush duhet të jetë në vëzhgim të këtyre problemeve.

Diversiteti dhe përfshirja mori vëmendjen në një nga konferencat më të mëdha botërore për inteligjencën-artificiale (AI) më 2018. Por kur një takim me reputacion të diskutueshëm, ai i “Neural Information Processing Systems” (NeurIPS), një konferencë kjo e mbajtur në Vankuver, Kanada, vëmendja mori një drejtim tjetër ndaj një çështjeje tjetër në të njëjtën fushë: etika.

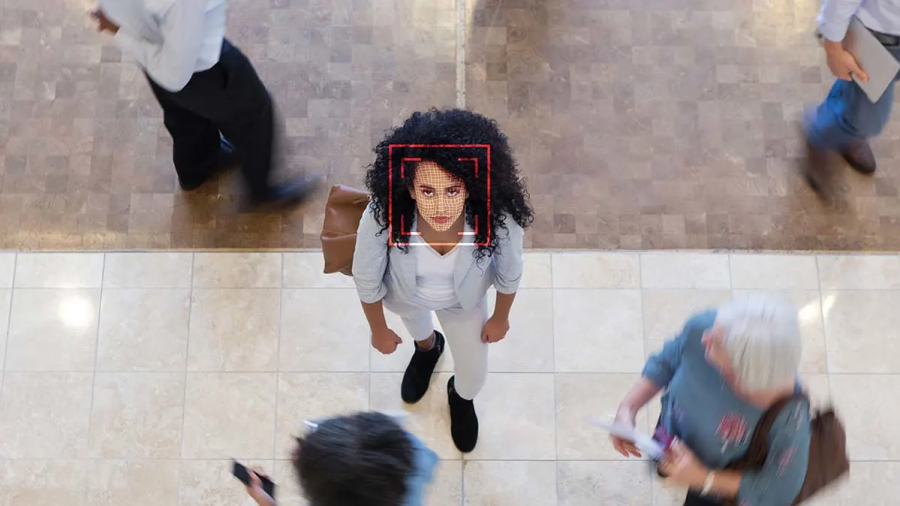

Fokusi vjen derisa AI kërkimet në rritje merren me diskutimet rreth etikës së aplikimit të kësaj teknologjie - siç janë policia parashikuese dhe njohja e fytyrës. Problemet përfshijnë trajtimin e paragjykimeve në algoritme të cilat reflektojnë informatat e diskriminimit në të dhëna, dhe ikja nga afektimi i popullatave të cenueshme.

“Nuk ka asgjë të quajtur platformë të teknologjisë neutrale”, paralajmëron Celeste Kidd, një psikologe e zhvillimit në Universitetin Berkley, Kaliforni, gjatë fjalimit të saj në NeurIPS në lidhje me ndikimin e algoritmeve në besimin e njerëzve. Në takimin, i cili pati një rekord me 13,000 të pranishëm, studiuesit provuan të shpjegojnë dhe të adresojnë me kuptim etikën dhe implementimin social të punës që kryejnë.

Hapësira etike

Eticistët kanë debatuar ndikimin e AI-së gjatë dhe kanë menduar mënyra se si të përdoret teknologjia për të mirë, si për shembull në kujdesin shëndetësor. Por hulumtuesit tani po mendojnë se duhet të përshtatin etikën në formulimin e kërkimeve dhe të kuptojnë dëmin potencial të padrejtësisë algoritmike, thotë Meredith Whittaker, një AI hulumtuese në Universitetin e New Yorkut dhe themeluesja e AI Now Institute, e cila tenton të kuptojë implikimet sociale të teknologjisë. Në konferencën e fundit të NeurIPS, hulumtuesit nuk mundën të “shkruajnë, flasin ose mendojnë” për këto sisteme pa e marrë parasysh dëmin ndaj shoqërisë, thotë ajo.

“Pyetja është, mos ndryshimi në bisedë rezultoi në ndryshimin e strukturës e cila na duhet për të siguruar se këto sisteme nuk do të shkaktojnë dëm?”

Konferencat sikur NeurIPS, të cilat, bashkë me dy të tjera vjetore, publikojnë shumicën e studimeve për AI, mbajnë përgjegjësi, thotë Whittaker. “Fusha është zgjeruar aq shumë sa s’ka mjaft konferenca ose recensentë. Por gjithkush dëshiron të dorëzojë hulumtimin. Kështu që ka një leverdi të madhe”, thotë ajo.

Por hulumtimi prezantuar në NeurIPS nuk ballafaqohet me një kontroll të etikës si pjesë e procesit të rishikimit. Grackat e kësaj ishin të përmbledhura nga reaksioni ndaj një hulumtimi të prezantuar në konferencë. Studimi pretendonte të mund të gjenerojë fytyra - duke përfshirë dhe moshën, gjininë dhe etnicitetin e individit - në parim të zërit. Shkencëtarët e mësimit të makinerisë e kritikuan në Twitter hulumtimin nga të qenit transforbik dhe pseudo-shkencor.

Zgjidhje potenciale

Një zgjidhje është të prezantosh vlerësime etike në konferenca. NeurIPS në 2019 përfshiu për herë të parë një listë kontrolli të riprodhueshmërisë për hulumtimet e dorëzuara. Në të ardhmen, kur pranohen, hulumtimet mund të kontrollohen për përgjegjësi, thotë Joelle Pineau, një shkencëtar i mësimit të makinerisë në McGill University në Montreal, Kanada, dhe në Facebook, i cili është në komitetin organizativ në NeurIPS dhe e zhvilloi këtë listë kontrolli.

NeurIPS thotë se një komitet etik është i gatshëm të merret me brengat gjatë një procesi vlerësues por po konsideron mënyra se si të bëjë punën në lidhje me etikën dhe ndikimin social më të qëndrueshme. Propozimet kërkojnë nga autorët të japin një deklaratë për etikën e punës së tyre dhe vlerësues të trajnimit të gjejnë shkelje të kornizës etike. Organizuesit e konferencës vjetore International Conference on Learning Representations - një tjetër AI konferencë e madhe - thanë se poashtu janë duke i diskutuar idetë për vlerësimin e studimeve duke mbajtur etikën në mend, mbas bisedimeve në bashkësi.

AI tani shkon edhe një hap përpara: në një raport të publikuar muajin e kaluar, ka thirrur për krejt hulumtimet lidhur me mësimin e makinerisë të përfshijnë seksion për dëmin shoqëror, poashtu edhe prejardhjen e të dhënave të tyre. Konsiderata të këtilla duhet të vënë në qendër perspektivën e grupit të cenuar, sipas të cilit AI tenton të ndikojë disproporcionalisht, thotë Abeba Birhane, një shkencëtare kognitive në University College Dublin, i tha NeurIPS në punishten e AI, në të cilën studimi i saj në ‘etikën mes marrëdhënieve’ fitoi çmimin e studimit më të mirë. “Algoritmet përjashtojnë punëtorë më të vjetër, njerëzit trans, imigrantët, fëmijët”, tha Birhane, duke cituar një përdorim të AI-së në punësim dhe mbikëqyrje. Zhvilluesit duhet pyetur jo vetëm si mund të përdoret algoritmi i tyre, por edhe a duhet të implementohet në rend të parë, tha ajo.

Ndikimet e biznesit

Kompanitë e teknologjisë - të cilat janë përgjegjëse për sasinë masovike të AI kërkimeve - janë poashtu duke adresuar etikën e punës së tyre (Google vetë ishte përgjegjës për 12% e hulumtimeve në NeurIPS, sipas një llogaritjeje). Por aktivistët thanë se ata nuk duhet të lejohen me 'larjen e etikës'. Kompanitë teknologjike nga mungesat e diversitetit, dhe megjithëse disa firma kanë borde të dedikuar ndaj etikës, aktivistët paralajmërojnë së këto borde shpesh kanë shumë pak fuqi. Zgjidhjet e tyre teknike - të cilat përfshijnë tentimet për të 'de-anësuar algoritmin' - janë shpesh të gabuara, thotë Birhane. Metoda në mënyrë të gabuar sugjeron që sasitë me të dhëna të 'de-anësuara' ekzistojnë, dhe duke rregulluar algoritmet nuk do t’i zgjedhim problemet rrënjësore në të dhënat e cekura, thotë ajo.

“T’i detyrosh kompanitë e teknologjisë të përfshijnë njerëz nga grupet e afektuara në borde të etikës, do të ndihmonte”, thotë Fabian Rogers, avokues i komunitetit në Shoqatën e Qiraxhinjve “Atlantic Towers”, në Brooklyn, New York. Rogers ia doli të parandalonte instalimin e teknologjisë për njohjen e fytyrës nga pronari kundër pëlqimit të banorëve. “Konteksti është gjithçka, dhe ne duhet të mbajmë ndërmend se kur flasim për teknologji, është vështirë ta bëjmë këtë pa prezencën e njerëzve të duhur për ta ofruar atë perspektivë”, tha ai.

Hulumtuesit dhe punëtorët teknikë në pozita të privilegjuara mund të zgjedhin se ku punojnë dhe të votojnë me këmbë, thotë Whittaker. Ajo ka punuar në Google deri në vitin e kaluar, dhe më 2018 organizoi një protestë e stafit së Googleit ndaj mënyrës se si firma po i trajtonte pretendimet për ngacmime seksuale. “Hulumtuesit duhet të kërkojnë të dinë rezultatin përfundimtar të asaj ku ata janë duke punuar”, thotë ajo.

Një qasje tjetër do të ishte të ndryshojmë pyetjet të cilat po tentojnë të zgjidhen, thotë Ria Kalluri, një shkencëtare e mësimit të makinerisë në Stanford University në Kaliforni.

Shqipëroi: Fat Myftiu